2022年MOT新SOTA

论文:BoT-SORT: Robust Associations Multi-Pedestrian Tracking

代码:https://github.com/NirAharon/BOT-SORT

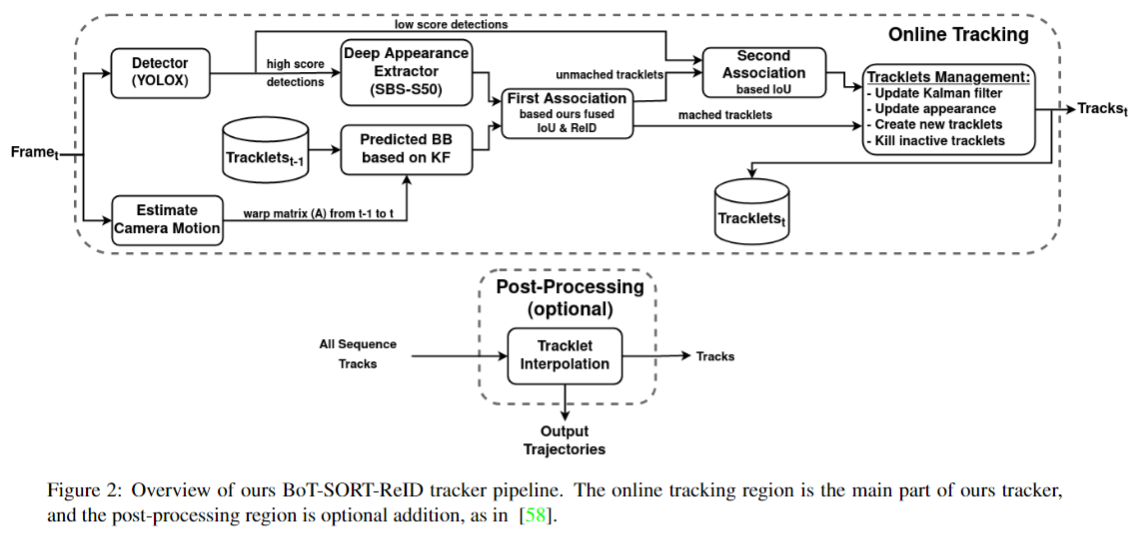

本篇工作达到了2022年MOT17和MOT20两个数据集的新SOTA。该方法是基于ByteTrack的改进,论文主要包括三个点:一是更改了卡尔曼滤波器中的状态向量(MOTA +0.01%, IDF1 +0.12%, HOTA +0.24%),二是添加了相机运动补偿(MOTA +0.64%, IDF1 +1.62%, HOTA +0.94%),三是提出了一种IoU和ReID余弦距离的融合方法(使用ReID MOTA +0.07%, IDF1 +0.54%, HOTA +0.06%)。标出的性能提升为在MOT17验证集的结果。接下来介绍一下这三个点的实现细节:

使用(cx, cy, w, h, cx', cy', w', h')作为卡尔曼滤波器的状态。而非之前使用的(cx, cy, s=w*h, r=w/h, cx', cy', s')或者(cx, cy, r=w/h, h, cx', cy', r', h')。

增加了相机运动补偿(CMC),具体做法是使用OpenCV中的全局运动补偿(GMC)的 RANSAC 算法得到仿射变换矩阵 $A_{k-1}^k\in \mathbb{R}^{2\times 3}$,然后卡尔曼滤波器中的预测状态 $\hat{x}_{k|k-1}$ 和协方差矩阵 ${P}_{k|k-1}$ 分别按如下公式应用仿射矩阵变为 $\hat{{x}}_{k \mid k-1}^{\prime}$ 和 ${P}_{k \mid k-1}^{\prime}$ :

$$

\begin{aligned}

A_{k-1}^k=&\left[M_{2 \times 2} \mid {T}_{2 \times 1}\right]=\left[\begin{array}{lll}

a_{11} & a_{12} & a_{13} \\

a_{21} & a_{22} & a_{23}

\end{array}\right] \\

\tilde{{M}}_{k-1}^k= & {\left[\begin{array}{cccc}

{M} & {0} & {0} & {0} \\

{0} & {M} & {0} & {0} \\

{0} & {0} & \boldsymbol{M} & {0} \\

{0} & {0} & {0} & {M}

\end{array}\right], \tilde{{T}}_{k-1}^k=\left[\begin{array}{c}

a_{13} \\

a_{23} \\

0 \\

0 \\

\vdots \\

0

\end{array}\right] } \\

& \hat{{x}}_{k \mid k-1}^{\prime}=\tilde{{M}}_{k-1}^k \hat{{x}}_{k \mid k-1}+\tilde{{T}}_{k-1}^k \\

& {P}_{k \mid k-1}^{\prime}=\tilde{{M}}_{k-1}^k {P}_{k \mid k-1} \tilde{{M}}_{k-1}^{k^{\top}}

\end{aligned}

$$

其中$M$代表缩放旋转变换,$T$代表平移变换。当高速情况下,这两项修正都必不可少;当相机相对于帧率变化较慢时,可以省略 ${P}_{k|k-1}$ 的修正。

此外还用了ReID,使用FastReID库的BoT(SBS),使用ResNeSt50作为骨干网络。使用指数滑动平均(EMA)更新第 $k$ 帧的第 $i$ 个轨迹的外观状态 $e_i^k$:

$$

e_i^k = \alpha e_i^{k-1}+(1-\alpha)f_i^k

$$

其中 $f_i^k$为外观embedding,$\alpha=0.9$

然后将轨迹和当前检测之间的外观余弦相似度距离 $d^{cos}$ 和 IoU距离 $d^{iou}$ 按照下面公式融合为一个距离矩阵 $C$,用于匈牙利匹配。两种距离的阈值分别取$\theta_{iou}=0.5, \theta_{emb}=0.25$。

$$

\begin{gathered}

\hat{d}_{i, j}^{\cos }=\left\{\begin{array}{l}

0.5 \cdot d_{i, j}^{\cos },\left(d_{i, j}^{\cos }<\theta_{e m b}\right) \wedge\left(d_{i, j}^{i o u}<\theta_{i o u}\right) \\

1, \text { otherwise }

\end{array}\right. \\

C_{i, j}=\min \left\{d_{i, j}^{i o u}, \hat{d}_{i, j}^{c o s}\right\}

\end{gathered}

$$

本文的方法整体流程图如下:

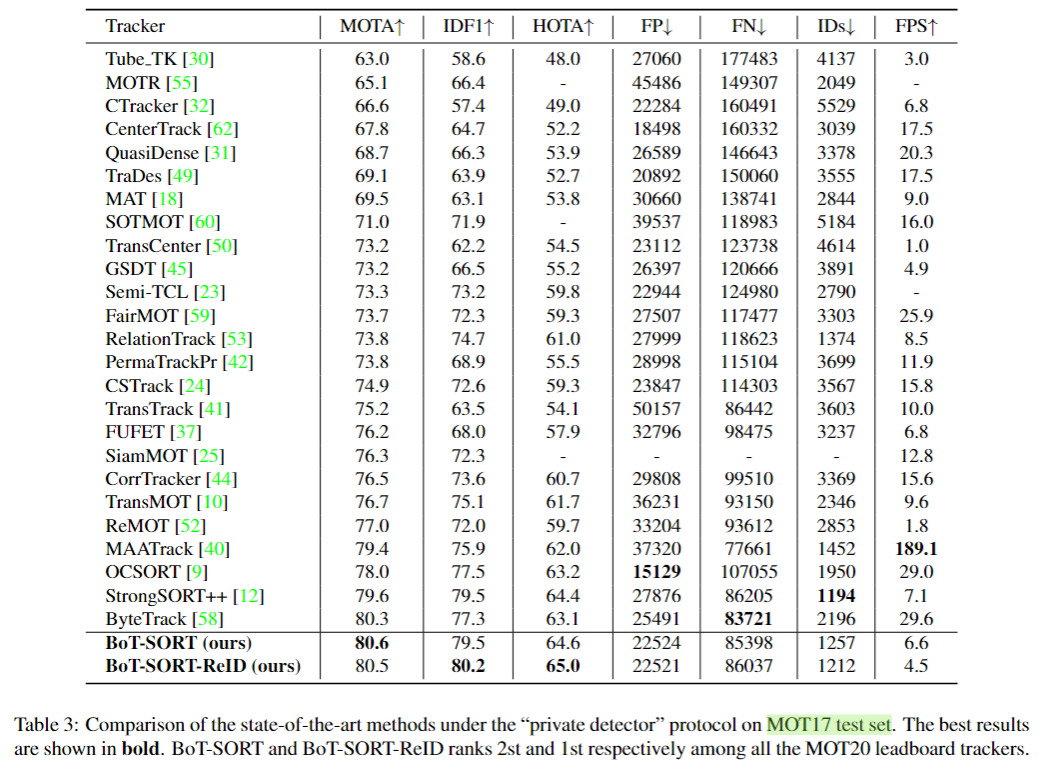

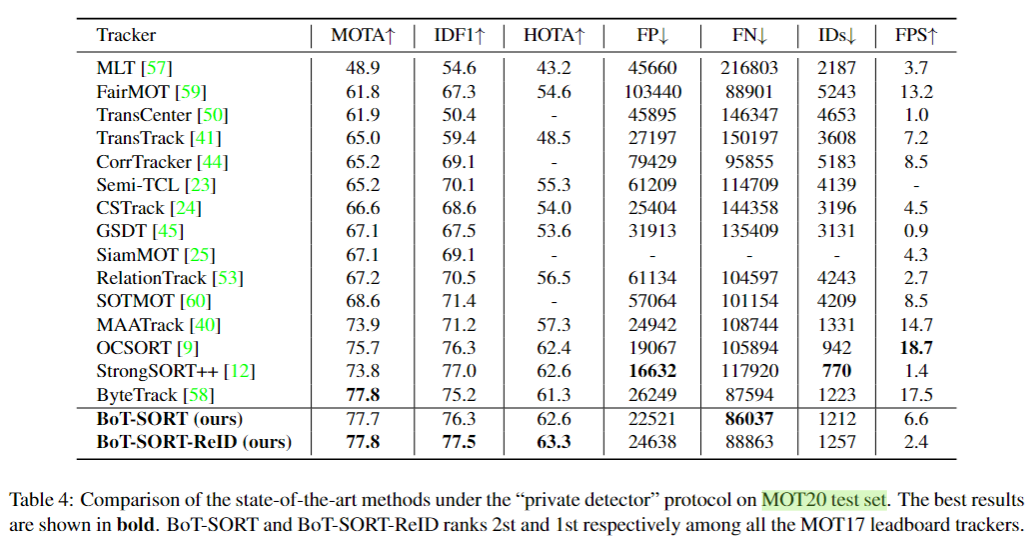

在MOT17和MOT20上的结果如下:

本方法的使用限制:在运动物体密度较高的场景中,由于缺乏背景关键点,可能导致相机运动补偿估计失败,从而导致意想不到的跟踪行为。另外CMC过程对算法速度有些影响。